很久没更新了,这次做了一个和导演基本没关系了的项目 demo(。)

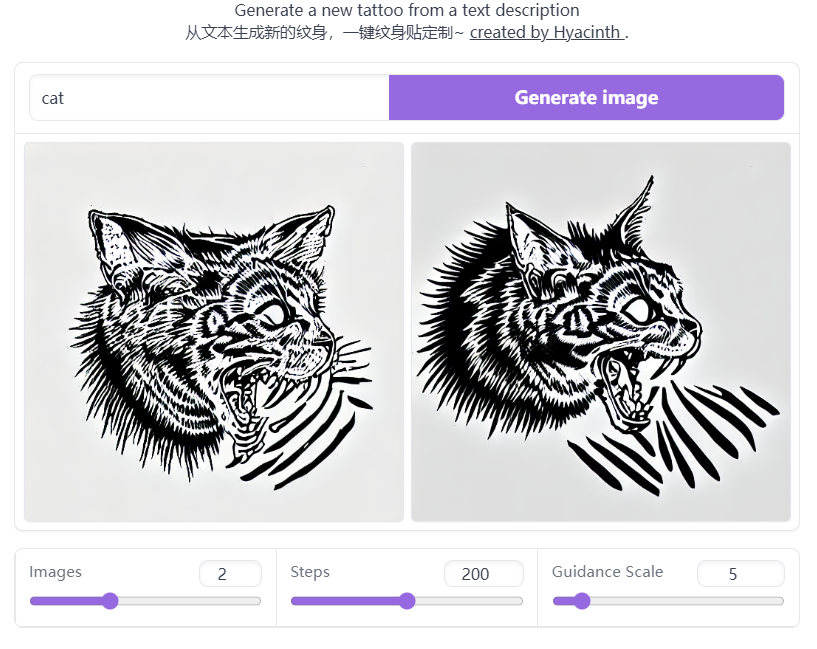

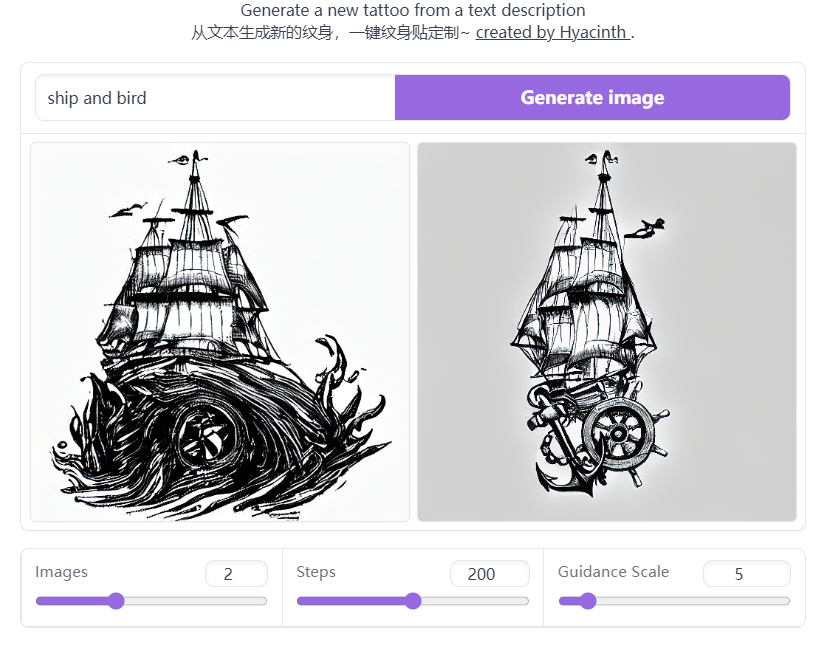

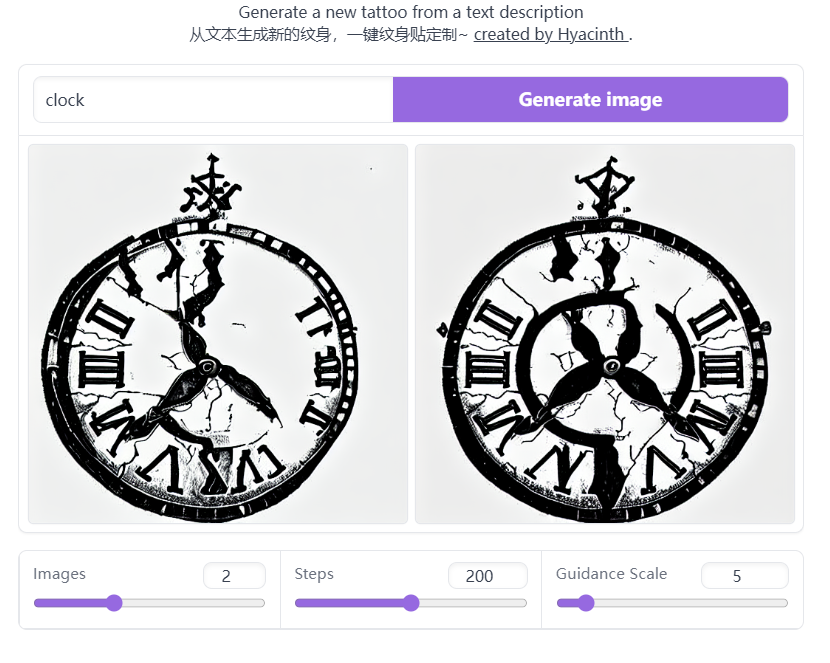

通过微调 Stable Diffusion 制作了一个 AI 纹身贴生成器,用户可以根据任意输入的文本,一键设计纹身贴,使用地址见后文。

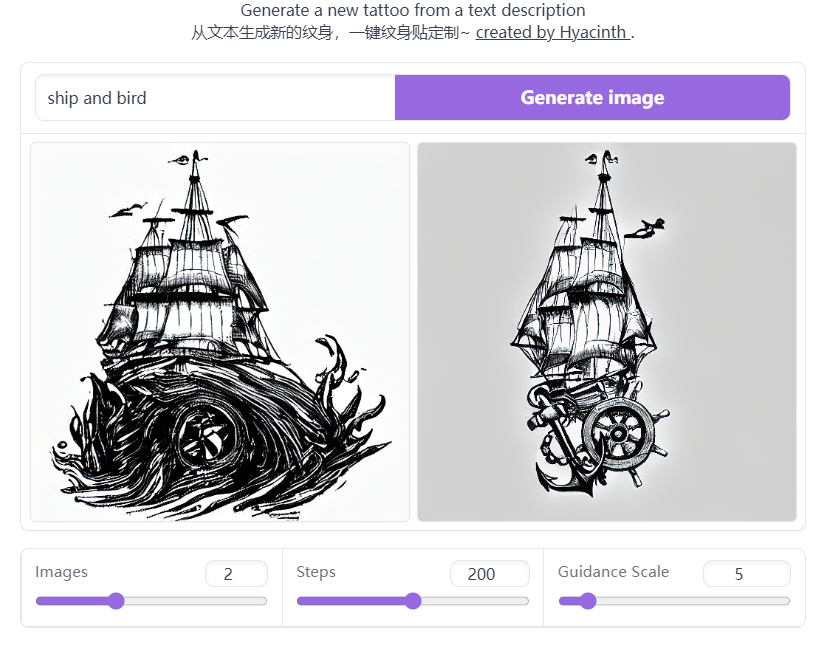

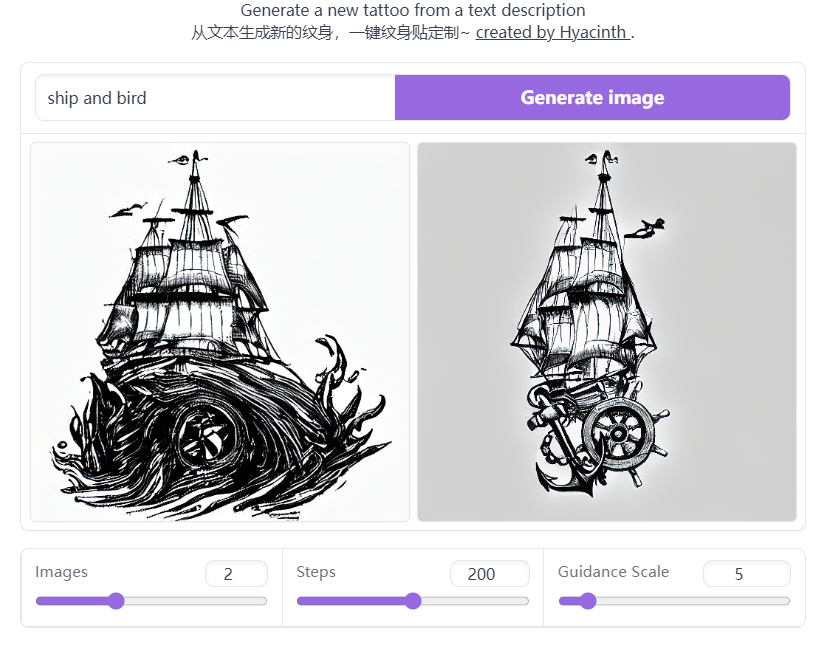

“船与鸟”

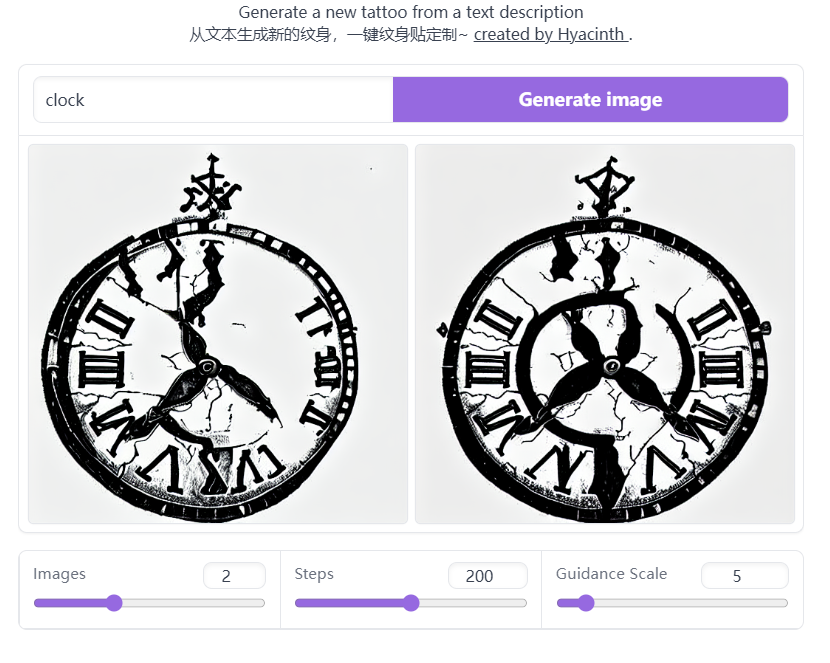

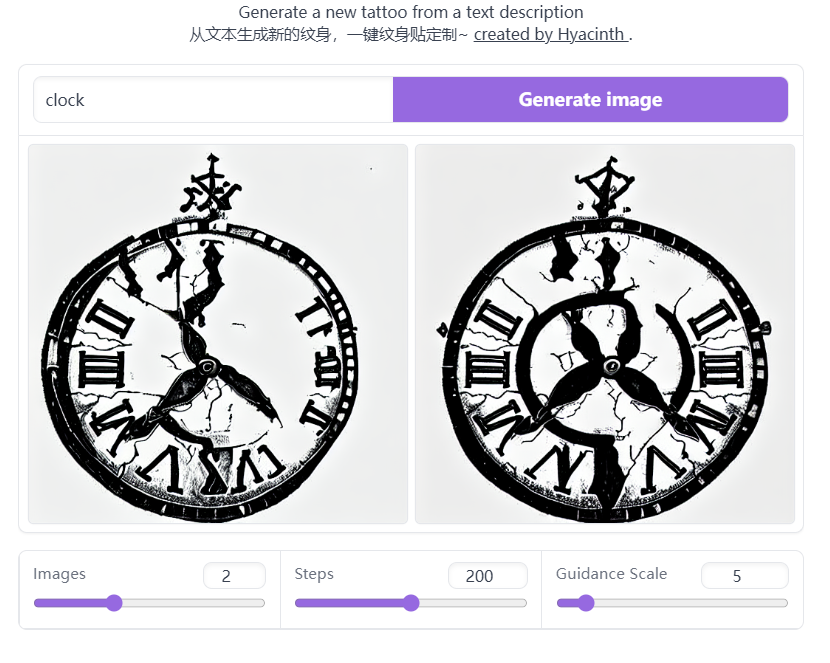

“钟表”

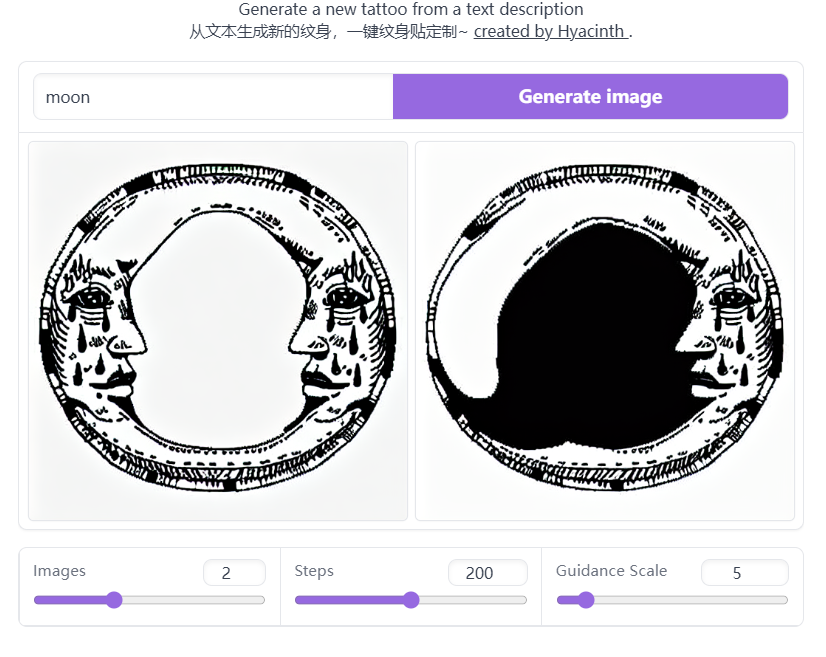

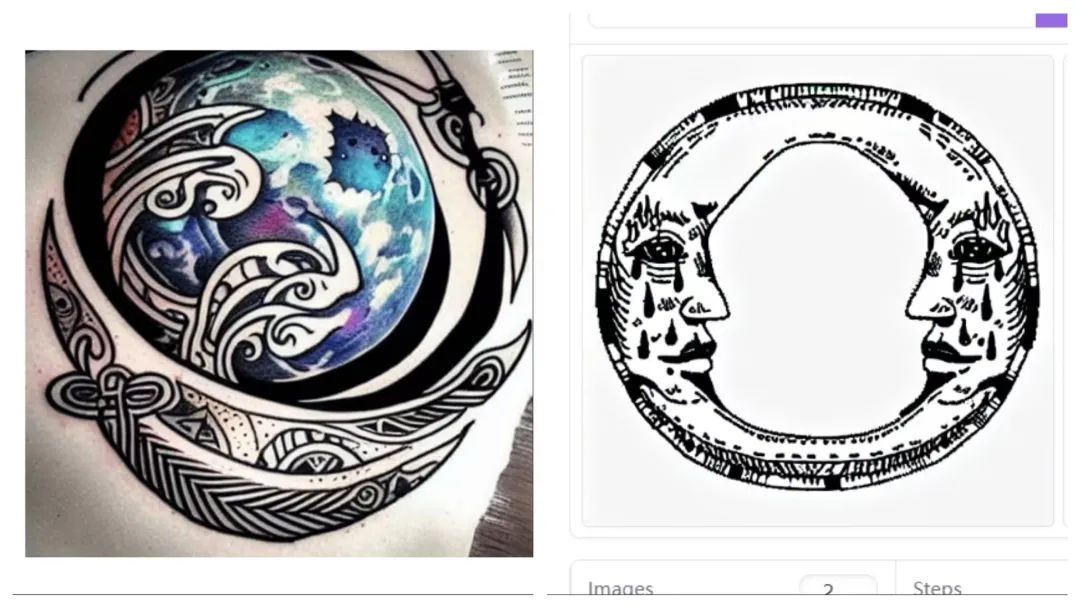

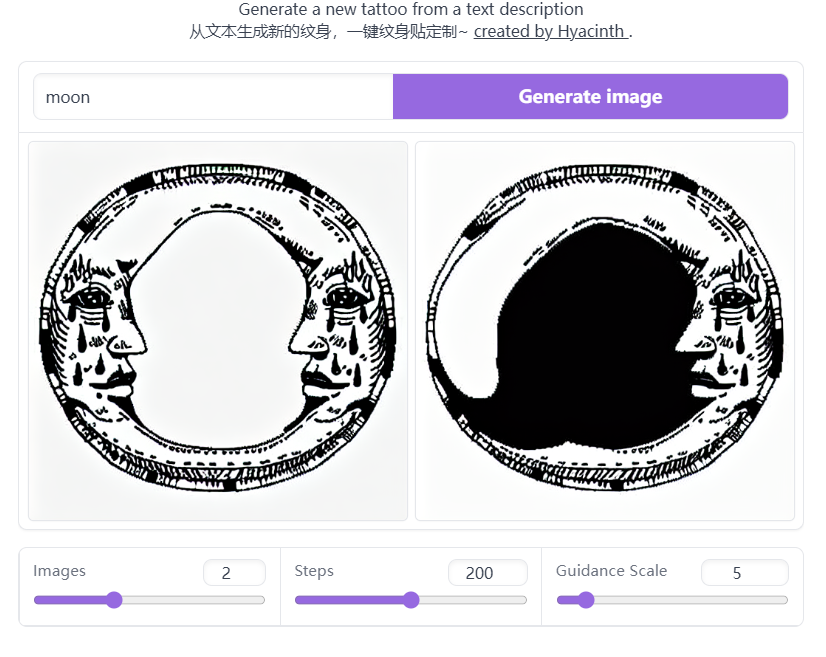

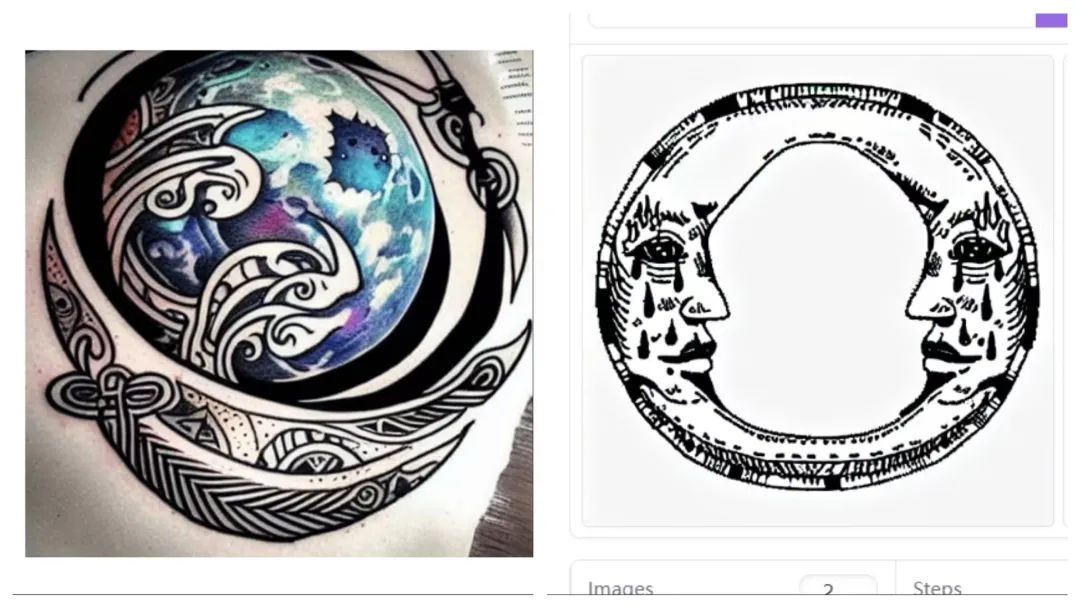

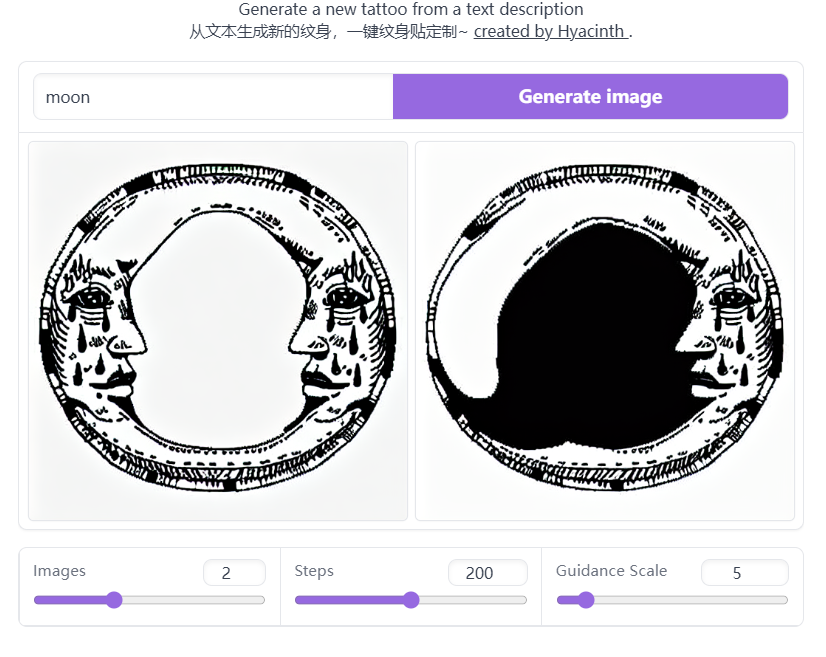

“月亮”

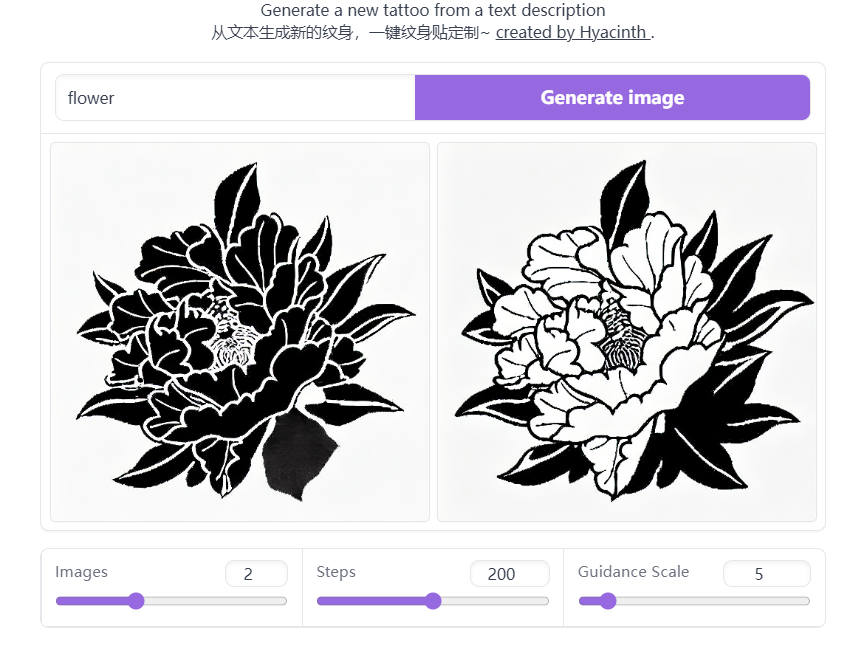

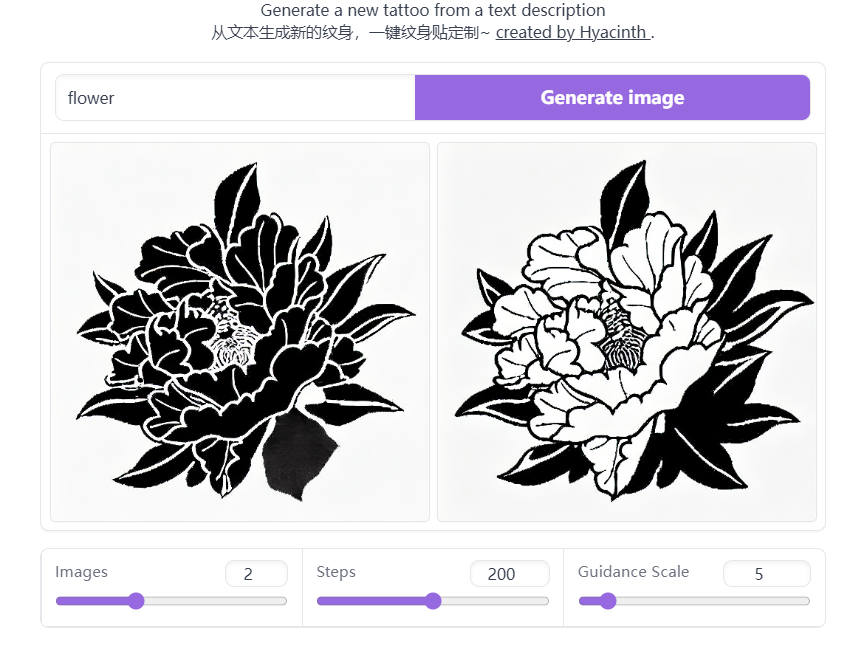

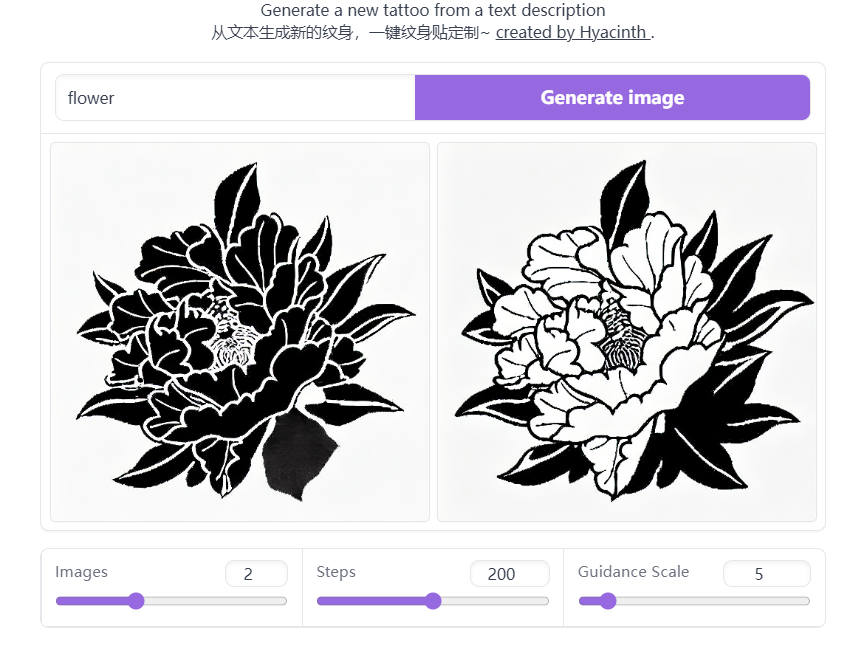

“花朵”

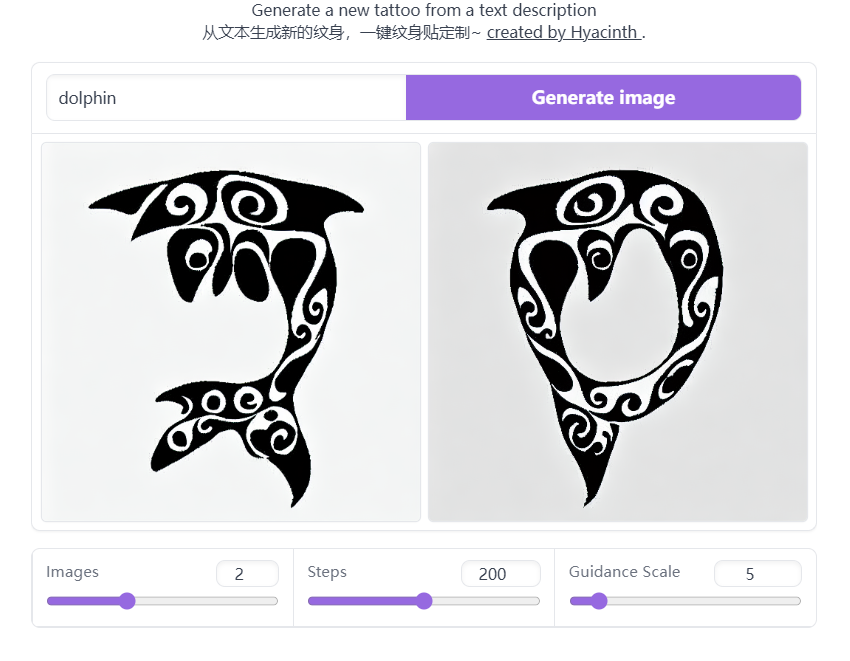

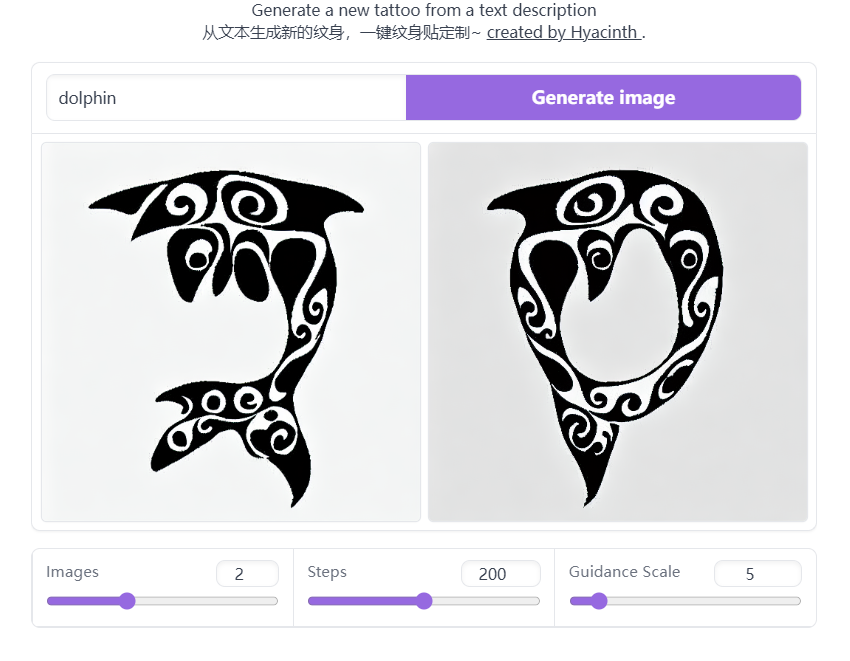

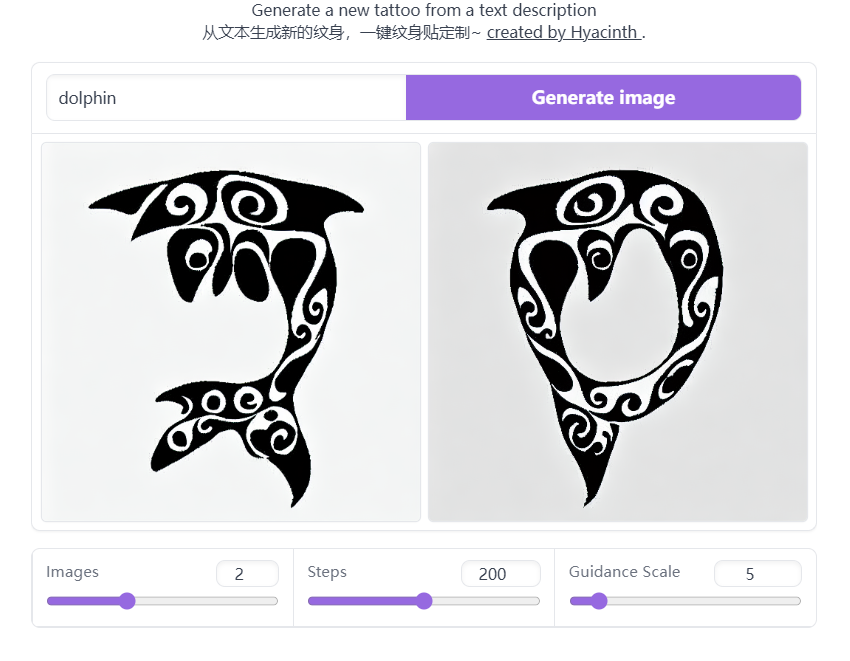

“海豚”

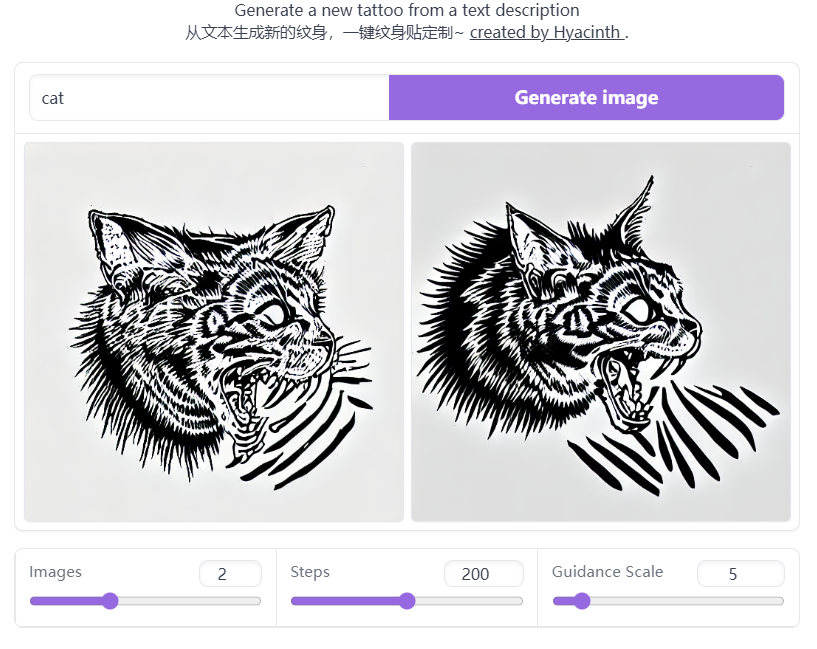

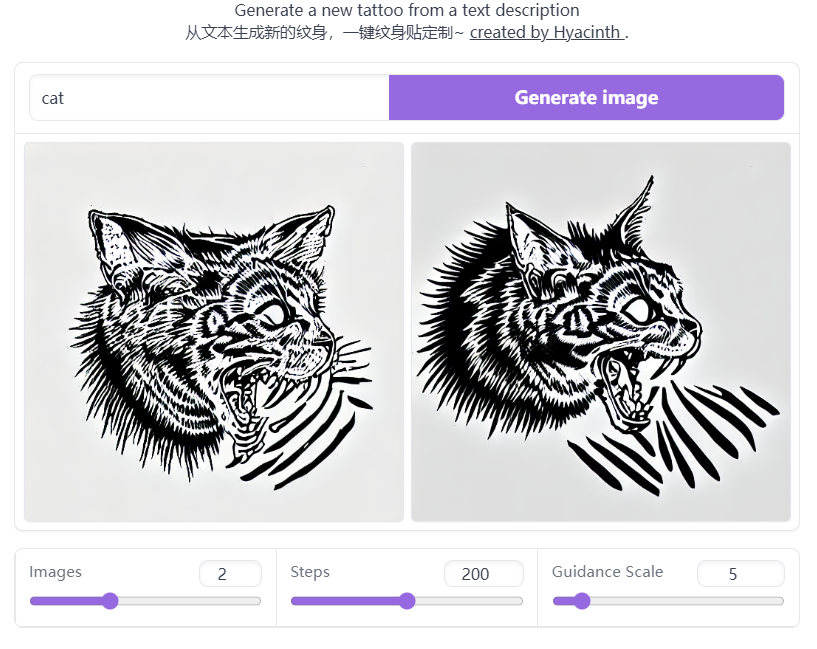

“猫”

Stable Diffusion 是一个很好的通用类大模型,但在生成特定风格的图片时常常不够方便,比如在“纹身”的场合,直接用 SD 生成的纹身大多会同时生成手臂、身体等部位,没有办法一键打印使用;同时也很难精准控制纹身图案的内容。上图中,左图是直接用 SD 生成的关于月亮的纹身,右图是微调 SD 模型后生成的月亮纹身。所以对于特殊场景的设计需求,调整 SD 模型可能是最优解,毕竟大吟唱术耗时费力还玄学。>> COLAB:https://colab.research.google.com/drive/1sKMIjbO_GZm-AqtoeYKX0b-fE_vhI09t?usp=sharing>> Huggingface:https://huggingface.co/ringhyacinth/tattoo-alpha-test/tree/main你可以在 COLAB 上直接生成,或者通过 Huggingface 下载测试模型。欢迎在使用后告诉我你的反馈意见,我们会根据大家的意见进行优化,如果优化成功的话,正式版预计在 11 月月初发布,如果优化失败的话,这个项目就窗了。哈哈哈。 * 毕竟是在测试阶段的 demo, 当然是禁止商用的。另外,在 fine-tuned 的过程中,我们也有一些遇到的问题,如果你碰巧知道这个问题的答案也欢迎和我们交流!后台留言告诉我您的微信即可!

1. 不知道为什么 ckpt 转 diffuser 后,模型效果差了很多,我们用的脚本是:https://github.com/justinpinkney/stable-diffusion/blob/main/scripts/convert_sd_to_diffusers.py2. 我们用了 Blip 来给数据集做标注,效果不是很好,手动标注数据集量还是太大了,不知道有没有推荐的更好的办法?3. 如何判断 fine tuned 过程中的最佳训练步数?这点似乎是很感性的经验,期待交流~!

powered by Stable Diffusion